¡Síguenos!

TwittearVisitas: 818

EN FORMAS grandes y pequeñas, la inteligencia artificial (IA) se ha vuelto omnipresente. Los motores de búsqueda, los mapas y las redes sociales analizan nuestras historias para hacer pronósticos y proporcionar respuestas personalizadas relevantes. Las aplicaciones de texto y de correo electrónico, que conocen las palabras y frases que usamos con mayor frecuencia, tratan de completar las frases que escribimos.

Igualmente, programas de inteligencia artificial como AlphaGo y AlphaZero ganan en distintos juegos (en este caso, Go y ajedrez, respectivamente) jugando por sí mismos y, al hacerlo, desarrollan sus propios conceptos no tan humanos de dichos juegos. En el MIT, un programa de IA descubrió un nuevo antibiótico al identificar patrones de datos que los seres humanos no pudieron descubrir, y que posiblemente nunca habrían podido hacerlo.

Sorprendido por este y otros avances, el equipo estelar integrado por el exsecretario de Estado de Estados Unidos Henry Kissinger, el cofundador de Schmidt Futures y exdirector ejecutivo de Google Eric Schmidt y el decano de la Escuela Schwarzman de Computación del MIT Daniel Huttenlocher se han reunido para analizar la inteligencia artificial, cómo evolucionó, dónde se encuentra ahora y a dónde nos llevará en el futuro

En este extracto de su libro, The Age of IA: And Our Human Future (La era de la IA y nuestro futuro humano), analizan las transformaciones que la IA impondrá en la planificación, preparación y ejecución de la guerra. Su conclusión es que los seres humanos siguen siendo indispensables en la ecuación.

—∞—

En toda la historia, la influencia política de una nación se ha correlacionado con su poder militar; en otras palabras, su capacidad de infligir un daño a otras sociedades. Sin embargo, el equilibrio basado en el poder militar no es estático. Se basa en el consenso, de manera importante, entre todos los miembros del sistema internacional, sobre lo que constituye el poder, qué hace que el poder sea legítimo y qué miembros tienen la capacidad y la intención de usar su poder para tratar de imponer su voluntad. Cuando los miembros no están de acuerdo con respecto a la naturaleza del poder que define su equilibrio, se arriesgan al conflicto, especialmente, al conflicto derivado de un error de cálculo.

En años recientes, la formación de un consenso se ha complicado por la llegada de las armas cibernéticas. Dado que este tipo de armas tienen aplicaciones civiles, incluso su condición de armas es ambigua. En algunos casos, sus aportaciones al ejercicio o aumento del poder deriva en que las naciones que las poseen rehúsan reconocer su existencia o, cuando menos, reconocer el alcance completo de sus capacidades.

Así, las verdades estratégicas tradicionales (qué constituye un conflicto entre las partes beligerantes, qué pueden hacer los rivales o qué tan rápido pueden hacerlo), no se traslada directamente al mundo digital. De hecho, una importante paradoja de la época es que cuanto más digital es una sociedad, tanto más vulnerable se vuelve. Las redes de comunicaciones, las centrales y las redes eléctricas, los mercados financieros, las universidades, los hospitales, las líneas aéreas y los sistemas públicos de tránsito, e incluso los mecanismos de la política democrática, dependen ahora de sistemas que, en distintos grados, son vulnerables a manipulaciones o ataques.

El gran maestro surcoreano del Go, Lee Se-Dol, desafía a la supercomputadora AlphaGo en 2016. (Foto: Jung Yeon-Je/AFP/Getty)

Como resultado, las economías avanzadas, que son las más grandes usuarias de servidores y sistemas en la nube, se han convertido en conjuntos de objetivos más codiciados. Por el contrario, en caso de una perturbación digital, los Estados con poca tecnología, las organizaciones terroristas e incluso los atacantes individuales podrían llegar a la conclusión de que tienen menos que perder.

Ningún ciberactor, gubernamental o no, ha revelado todo el alcance de sus capacidades o actividades, ni siquiera para disuadir las acciones de otros. Por ello, la estrategia y la doctrina han evolucionado en las sombras, aun cuando han surgido nuevas capacidades. Actualmente, la inteligencia artificial (IA) explora la vinculación entre armas que ya de por sí son complejas, complicando aún más la creación de estrategias y arriesgándose a impulsarla más allá de la intención humana, o incluso de su comprensión.

La guerra siempre ha sido incierta y contingente. Pero también se han guiado por una lógica, así como por un conjunto de limitaciones: las humanas. Sin embargo, la inteligencia artificial está impulsada por algoritmos que pueden identificar patrones y hacer pronósticos más allá de las posibilidades humanas. En consecuencia, la IA puede resolver problemas o desarrollar estrategias que los seres humanos, por sí solos, no han logrado, y quizá nunca puedan conseguir.

El jugador chino Ke Jie, de 19 años, se enfrenta a AlphaGo en 2017. (Foto: STR/AFP/Getty)

En los juegos, logros como los de AlphaGo y AlphaZero (programas de Google DeepMind que dominaron el Go y el ajedrez jugando ellas mismas, y que luego derrotaron a expertos humanos con el empleo de estrategias que sorprendieron e incluso confundieron a dichos expertos) han demostrado este principio. En el ámbito de la seguridad, es posible, e incluso probable, que la exploración de vínculos de la IA para la planificación o simulación de la guerra produzca resultados igualmente sorprendentes. Si los ejércitos y los servicios de seguridad que entrenan o se asocian con la inteligencia artificial obtienen conocimientos o influencias que no esperaban, tendrán que enfrentarse a la pregunta: ¿aquello que sorprende también debería desconcertar?

Si la IA consume datos, aprende de ellos y reacciona adaptándose y evolucionando, es posible que incluso los países que produzcan o utilicen armas diseñadas o manejadas mediante inteligencia artificial no sepan exactamente cómo, o qué tan poderosamente, se comportarán dichas armas. ¿Cómo desarrollar una estrategia (ofensiva o defensiva) para algo que percibe aspectos del entorno que los humanos podrían no percibir, o que quizá no perciban tan rápidamente, y que puede aprender y cambiar mediante procesos que, en algunos casos, superan la velocidad o el alcance del pensamiento humano?

Las posibles funciones defensivas de la IA funcionan en varios niveles y es posible que pronto resulten indispensables. De hecho, los aviones de combate piloteados por inteligencia artificial han mostrado una importante capacidad de superar a los pilotos humanos en combates aéreos simulados. Con el uso de algunos de los mismos principios generales que permitieron las victorias de AlphaZero en el ajedrez y el descubrimiento de la halicina, el antibiótico antibacteriano, la IA puede identificar patrones de conducta que ni siquiera el adversario puede planear o notar, y más adelante, recomendar métodos para contrarrestarlos.

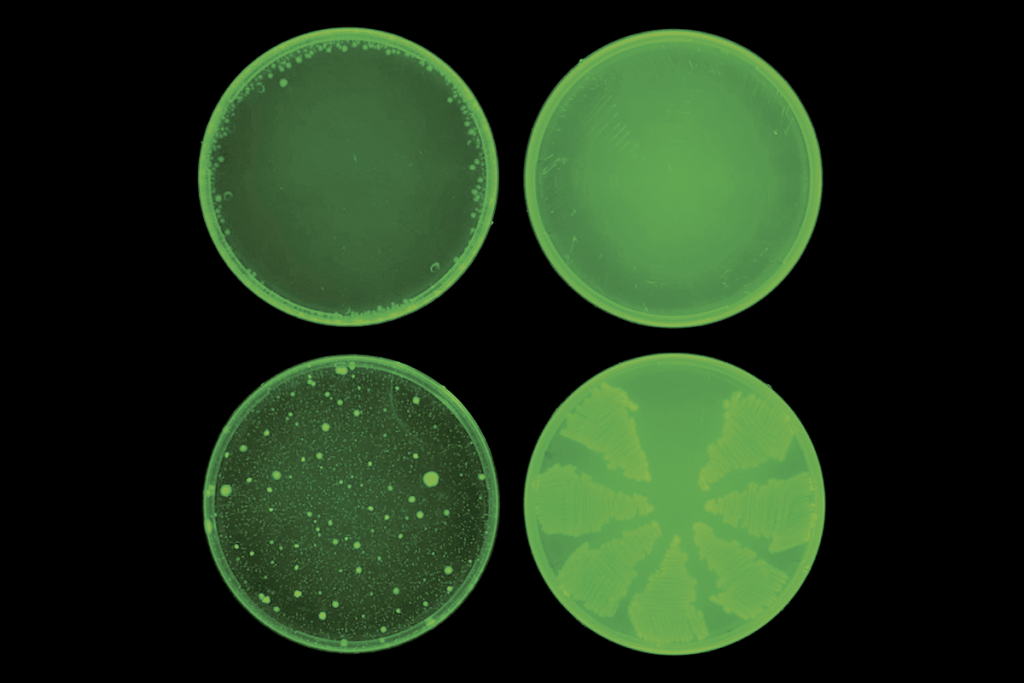

La halicina (arriba), desarrollada por un algoritmo de aprendizaje de máquina, previene la resistencia a los antibióticos de la bacteria E. coli, mientras que la ciprofloxacina (abajo) no tiene ese efecto. (Foto: cortesía del Laboratorio Collins del MIT)

En un conflicto tradicional, la psicología del adversario es un punto focal muy importante al cual dirigir la acción estratégica. La IA solo conoce sus instrucciones y sus objetivos, sin moral ni duda. Sin embargo, debido a que se adapta en respuesta a los fenómenos con los que se encuentra, si se despliegan dos sistemas de armas de IA para enfrentarse entre sí, es poco probable que alguno de ellos pueda pronosticar con precisión los resultados que generará su interacción, ni sus efectos colaterales.

Es posible que solo distingan de manera imprecisa sus capacidades respectivas, además de los castigos mutuos que recibirán por entrar en conflicto. Para los ingenieros y constructores, estas limitaciones podrían dar prioridad a la velocidad, al alcance de los efectos y a la resistencia; atributos que podrían hacer que los conflictos fueran más intensos y se percibieran en forma más generalizada, pero, sobre todo, que fueran menos predecibles.

No obstante, el efecto más impredecible podría ocurrir en el punto en que la IA y la inteligencia humana se encuentren frente a frente. Históricamente, los países que han elaborado planes de batalla han sido capaces de comprender, aunque de manera imperfecta, las doctrinas, tácticas y psicología de sus adversarios. Esto ha permitido el desarrollo de estrategias y tácticas de confrontación, así como de un lenguaje simbólico de acciones militares de demostración, como la intercepción de un avión en una frontera o de un bote en una vía fluvial en disputa. Sin embargo, cuando un ejército usa la IA para planear o establecer un objetivo, o incluso para dar asistencia dinámica durante un patrullaje o un conflicto, los conceptos e interacciones con los que estamos familiarizados podrían volverse extraños de una nueva manera, en cuanto que implican comunicarse e interpretar a una “inteligencia” cuyos métodos y tácticas no nos resultan familiares.

Fundamentalmente, el cambio a la IA y a las armas y sistemas de defensa asistidos por inteligencia artificial implica confiar, y en casos extremos, delegar la operación de un paradigma experiencial fundamentalmente distinto, a una inteligencia con un potencial analítico considerable. Esa dependencia introducirá riesgos desconocidos o poco comprendidos. Por esta razón, los operarios humanos deben participar y posicionarse para supervisar y controlar las acciones de la IA que podrían tener efectos letales. Aun cuando esto no evita todos los errores, por lo menos garantizará que exista una capacidad moral y que haya una rendición de cuentas.

Sin embargo, el desafío más profundo podría ser de carácter filosófico. Si los aspectos de la estrategia llegan a funcionar en ámbitos conceptuales y analíticos que son accesibles para la IA, pero no para la razón humana, se volverán opacos en cuanto a sus procesos, alcance e importancia definitiva. Si los encargados de crear políticas llegan a la conclusión de que la ayuda de la inteligencia artificial para explorar los patrones más profundos de la realidad es necesaria para comprender las capacidades y las intenciones de los adversarios (que podrían tener su propia IA) y responderles de manera oportuna, la delegación de las decisiones críticas a las máquinas podría volverse inevitable.

Es probable que las sociedades alcancen límites instintivos diferentes en cuanto a qué delegar y qué riesgos y consecuencias se pueden aceptar. Los principales países no deben esperar a que se produzca una crisis para iniciar un diálogo sobre las implicaciones estratégicas, doctrinales y morales de estas evoluciones. Si lo hacen, es probable que el impacto sea irreversible. Un intento internacional para limitar estos riesgos resulta imperativo.

Con tanta conectividad, desde las centrales eléctricas hasta los sistemas autónomos de vuelo que permiten que dos o más aeronaves vuelen en estrecha formación por largas distancias, mejorando la eficiencia en el uso del combustible, paradójicamente, “la desconexión podría convertirse en la forma definitiva de defensa”. (Foto: NASA)

La búsqueda de garantías y restricciones deberá contender con la naturaleza dinámica de la IA. Una vez que sean liberadas al mundo, las armas cibernéticas asistidas por inteligencia artificial podrían ser capaces de adaptarse y aprender mucho más allá de sus objetivos; de hecho, las capacidades mismas de las armas podrían cambiar conforme la IA reacciona a las circunstancias. Si las armas pueden cambiar en formas distintas en cuanto a su alcance o tipo con respecto a lo que sus creadores pronosticaron o amenazaron, los cálculos de disuasión y escalada podrían volverse ilusorios.

Debido a esto, la variedad de actividades que la inteligencia artificial puede realizar, tanto en la fase inicial de diseño como en la de despliegue, podría requerir ajustes, de manera que un ser humano siga teniendo la capacidad de supervisar y desactivar o redirigir un sistema que ha comenzado a divagar. Para evitar resultados inesperados y potencialmente catastróficos, tales restricciones deberán ser recíprocas.

Será todo un desafío definir las limitaciones para la IA y las capacidades cibernéticas, y la proliferación de armas será difícil de contener. Las capacidades desarrolladas y utilizadas por las principales potencias podrían caer en manos de terroristas y actores enemigos. De igual manera, las naciones más pequeñas que no poseen armas nucleares y tienen una capacidad limitada de armas convencionales podrían ejercer una gran influencia al invertir en inteligencia artificial de vanguardia y arsenales cibernéticos.

Infantes de marina prueban tecnología de visión nocturna. (Foto: Lance Cpl. Rhita Daniel/U.S. Marine Corps)

Inevitablemente, los países delegarán tareas discretas y no letales a los algoritmos de IA (algunos de ellos, manejados por entidades privadas), incluida la realización de funciones defensivas que detecten y prevengan intrusiones en el ciberespacio. La “superficie de ataque” de una sociedad digital altamente interconectada será demasiado amplia para que los operadores humanos puedan defenderla manualmente. Conforme muchos aspectos de la vida humana se realizan en línea y las economías continúan digitalizándose, algún actor enemigo podría desplegar un arma cibernética de inteligencia artificial para causar perturbaciones en sectores concretos. Los países, las empresas e incluso las personas deberían invertir en salvaguardas que les permitan protegerse en esas situaciones.

La forma más extrema de ese tipo de protección implica cortar las conexiones de redes y sacar de línea a los sistemas. Para las naciones, la desconexión podría convertirse en la forma definitiva de defensa. Aparte de estas medidas tan extremas, solo la IA será capaz de realizar ciertas funciones vitales de ciberdefensa, debido en parte a la enorme magnitud del ciberespacio y al conjunto casi infinito de posibles acciones que se pueden ejecutar en su interior. Por ello, es probable que las capacidades defensivas más importantes en este ámbito solo estén al alcance de unas cuantas naciones.

Más allá de los sistemas de defensa asistidos por IA se encuentra la categoría de capacidades más desconcertante: los sistemas autónomos de armas letales, que generalmente incluyen sistemas que, una vez activados, pueden seleccionar y atacar blancos sin mayor intervención humana. En este ámbito, el tema principal es la supervisión humana y la capacidad de una intervención humana oportuna

Un sistema autónomo podría tener un ser humano “sobre el bucle”, supervisando sus actividades de forma pasiva, o “dentro del bucle”, de manera que se requiera la autorización humana para ciertas acciones. A menos de que se restrinja mediante un acuerdo mutuo que sea observable y verificable, la forma de sistemas de armas descrita anteriormente podría llegar a abarcar estrategias y objetivos completos, como defender una frontera o lograr un objetivo particular contra un adversario, y funcionar sin una participación humana sustancial.

En estas situaciones, es imperativo garantizar una función adecuada para el juicio humano en la supervisión y dirección del uso de la fuerza. Tales limitaciones solo tendrán un significado limitado si únicamente una nación o un pequeño grupo de naciones las adoptan de manera unilateral. Los gobiernos de los países tecnológicamente avanzados deben explorar los desafíos de la restricción mutua apoyados por una verificación obligatoria.

La IA aumenta el riesgo inherente de la prevención y del uso prematuro, que pueden escalar hasta convertirse en un conflicto. Un país que tema que su adversario desarrolle capacidades automáticas podría buscar la prevención: si el ataque “tiene éxito”, podría no haber manera de saber si fue justificado o no. Para evitar una escalada no intencionada, las principales potencias deben efectuar su competencia dentro de un marco de límites verificables.

Un vehículo terrestre semiautónomo no tripulado, diseñado para preparar a los aviadores para enfrentar desafíos de seguridad del mundo real. (Foto: Matthew Porter/Airman 1st Class/U.S. Air Force)

La negociación no solo debe centrarse en moderar una carrera armamentista, sino también en asegurarse de que cada parte conoce, en términos generales, lo que hace la otra. Sin embargo, cada una de las partes debe esperar (y planificar en consecuencia) que la otra no revelará sus secretos más delicados desde el punto de vista de la seguridad. Nunca habrá una confianza absoluta. Sin embargo, como lo demostraron las negociaciones sobre armamento durante la Guerra Fría, esto no significa que no se pueda lograr cierta medida de entendimiento.

A pesar de todos sus beneficios, los tratados de control de armas (y los mecanismos de comunicación, aplicación y verificación que los acompañaron y que definieron a la era nuclear) no fueron históricamente inevitables. Fueron los seres humanos quienes los establecieron, no solo al reconocer nuestro riesgo mutuo, sino también nuestra responsabilidad mutua. N

—∞—

Extracto de The Age of AI (La era de la IA), de Henry A. Kissinger, Eric Schmidt y Daniel Huttenlocher. Copyright © 2021. Publicado en cooperación con Newsweek. Published in cooperation with Newsweek.